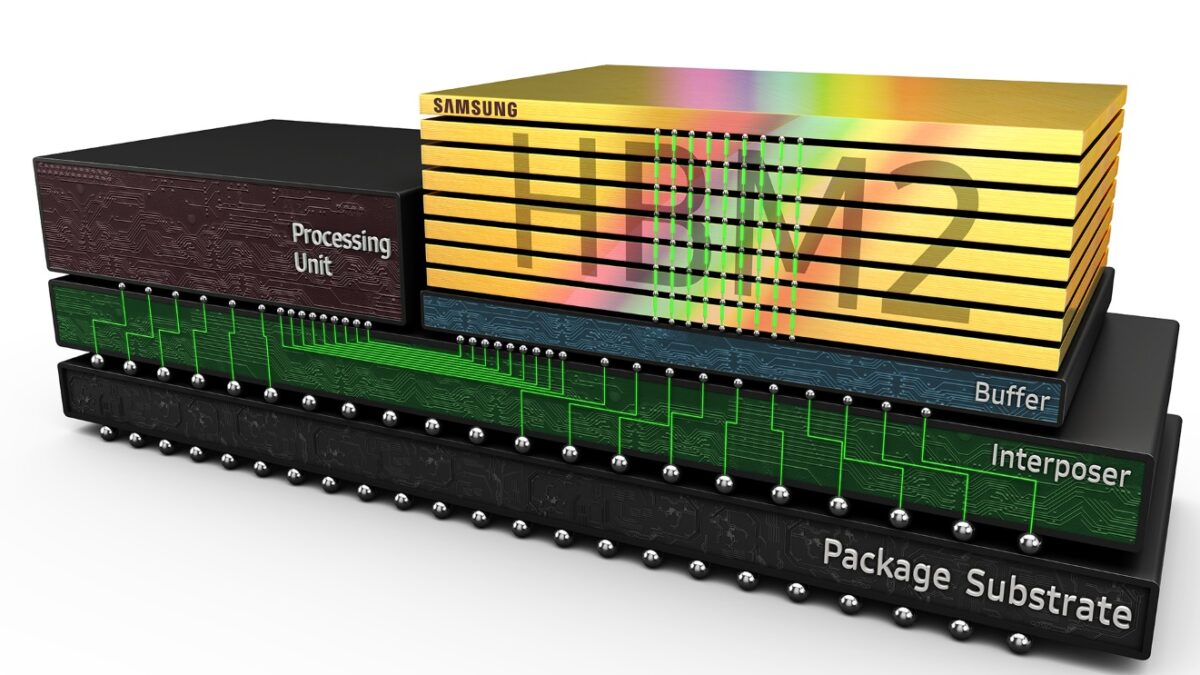

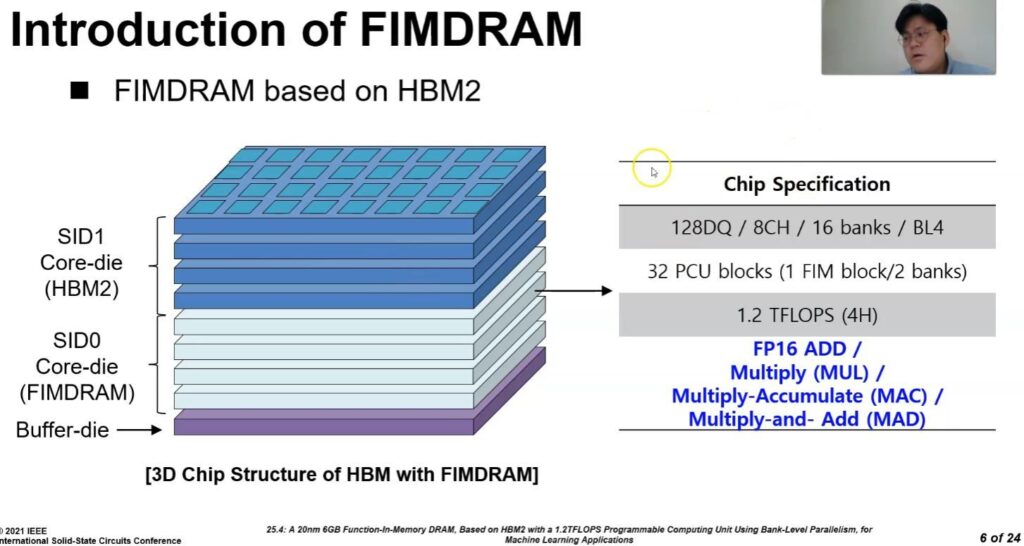

Samsung bugĂĽn, yeni HBM2 tabanlı belleÄźinin, 1,2 TFLOPS gömĂĽlĂĽ bilgi iĹźlem gĂĽcĂĽnĂĽ dışarı çıkarabilen ve belleÄźin kendisinin genellikle CPU’lar, GPU’lar, ASIC’ler veya FPGA’lar için ayrılmış iĹźlemleri gerçekleĹźtirmesine izin veren entegre bir AI iĹźlemcisine sahip olduÄźunu duyurdu.

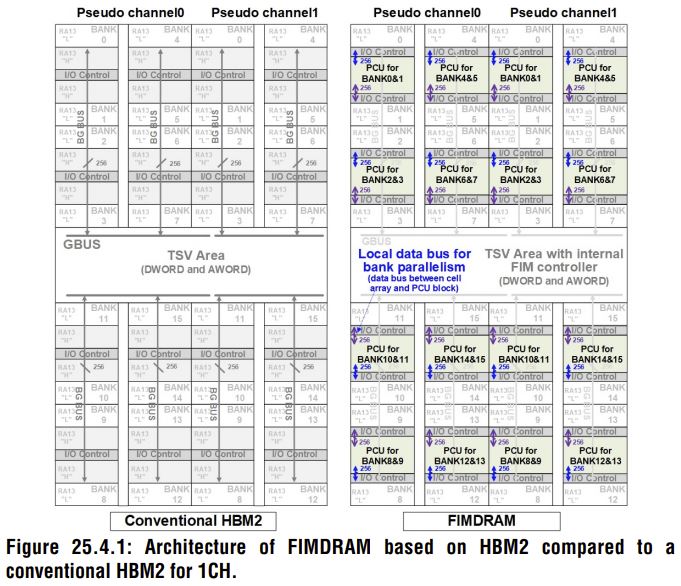

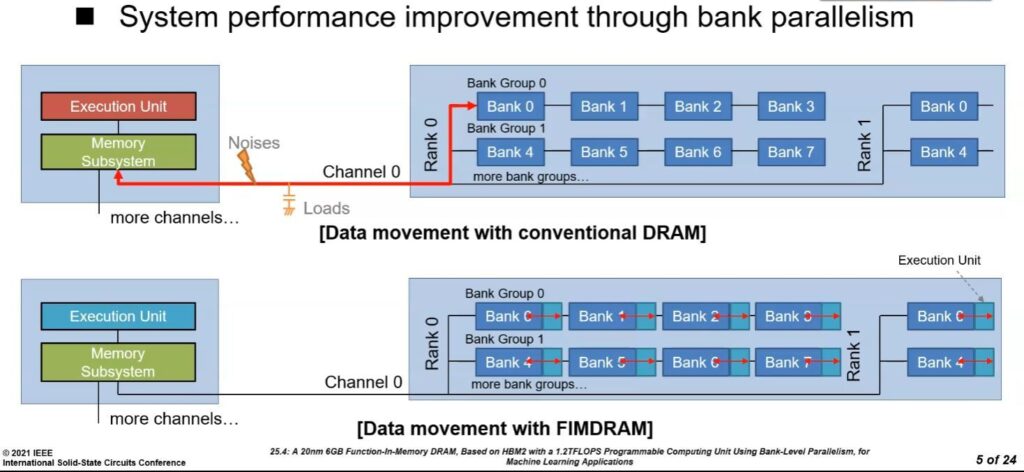

Yeni HBM-PIM (bellekte iĹźleme) yongaları, her bellek bankasının içine bir AI motoru enjekte ediyor. Böylece iĹźlemlerini HBM’nin kendisine aktarıyor. Bu yeni bellek sınıfı genellikle güç tĂĽketimi ve zaman açısından gerçek hesaplama iĹźlemlerinden daha pahalı olan bellek ve iĹźlemciler arasında veri taşıma yĂĽkĂĽnĂĽ hafifletmek için tasarlandı.

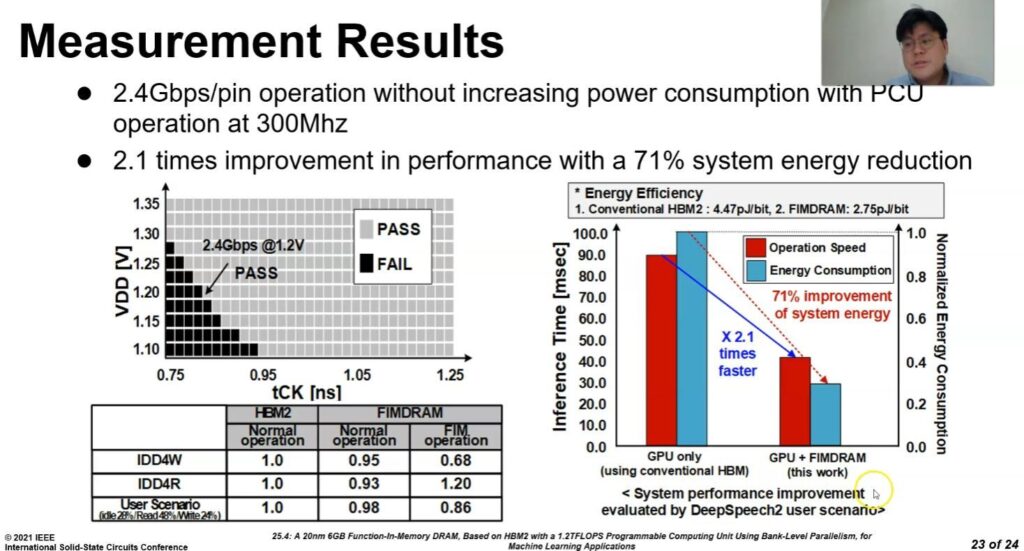

Samsung, mevcut HBM2 Aquabolt belleÄźine uygulandığında, teknolojinin enerji tĂĽketimini %70’ten fazla azaltırken iki kat daha fazla sistem performansı saÄźlayabileceÄźini söylĂĽyor. Ĺžirket ayrıca yeni belleÄźin, bellek denetleyicileri de dahil olmak ĂĽzere yazılım veya donanımda herhangi bir deÄźiĹźiklik gerektirmediÄźini ve böylece erken benimseyenler için daha hızlı pazarlama sĂĽresi saÄźladığını iddia ediyor. Samsung, belleÄźin zaten önde gelen AI çözĂĽm saÄźlayıcıları ile AI hızlandırıcılarda denemeler altında olduÄźunu ve Ĺźirketin tĂĽm doÄźrulamaların bu yılın ilk yarısında tamamlanarak pazara hızlı bir giriĹź yapacağını söylĂĽyor.

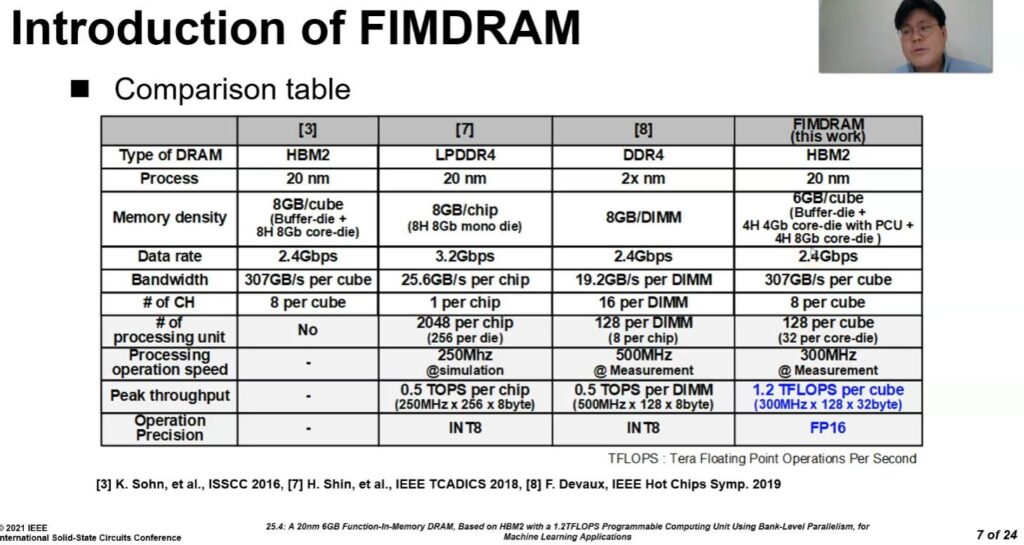

Ayrıca Samsung, bu hafta Uluslararası Katı Hal Devreleri Sanal Konferansı (ISSCC) sırasında yeni bellek mimarisinin daha ince ayrıntılarını sundu.

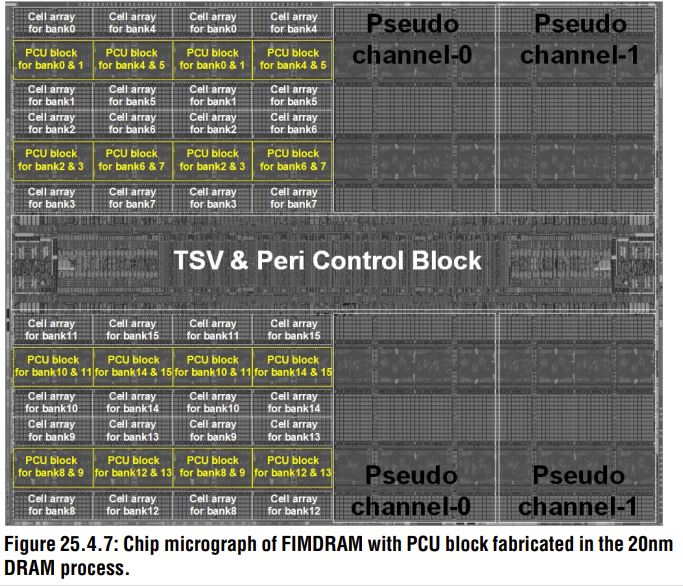

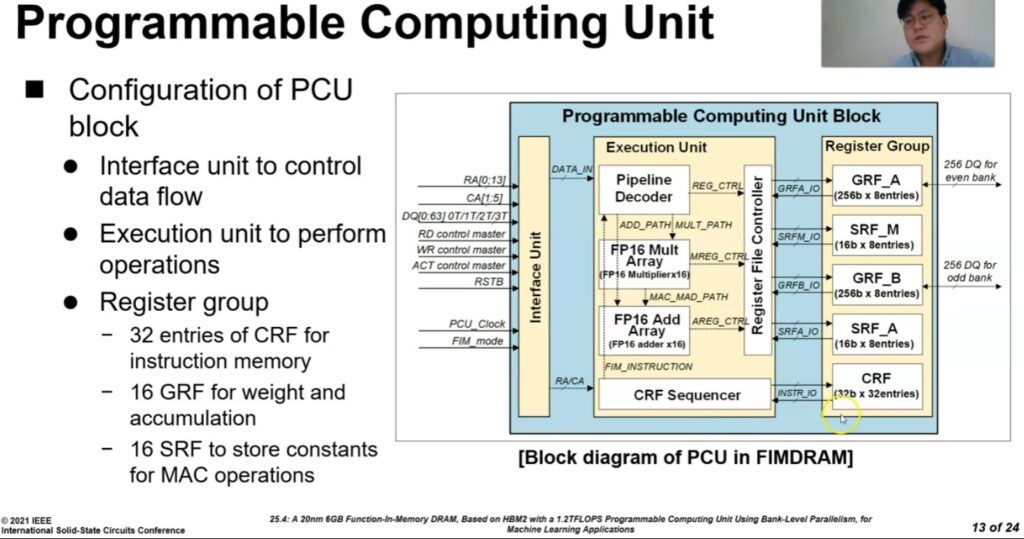

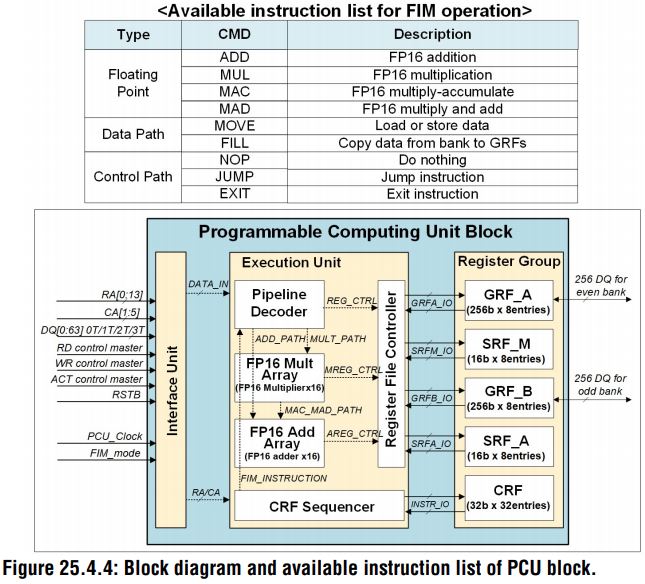

Yukarıdaki slaytlarda görebileceÄźiniz gibi yeni bellekte, her bellek yuvasına gömĂĽlĂĽ 300 MHz’de çalışan bir Programlanabilir Hesaplama Birimi (PCU) bulunuyor. Bu birim, DRAM içi hesaplamaları etkinleĹźtirmek için ana bilgisayardan gelen geleneksel bellek komutlarıyla kontrol edilip standart veya FIM (hesaplama) modunda çalışabiliyor.

Ă–zellikle, yukarıdaki slaytlar teknolojiye Function-In Memory DRAM (FIMDRAM) olarak atıfta bulunuyor. Ancak bu HBM-PIM adını taşıyan teknolojinin dahili kod adıydı. Ne yazık ki, bu teknolojiyi en son çıkan GPU’larda en azından Ĺźimdilik göremeyeceÄźiz. Samsung yeni belleÄźin veri merkezlerinde, HPC sistemlerinde ve yapay zeka destekli mobil uygulamalardaki bĂĽyĂĽk ölçekli iĹźleme gereksinimlerini karşılamaya yönelik olduÄźunu belirtiyor.